etcd详解 Raft算法如何保证强一致性,及其数据处理与存储对服务的支持

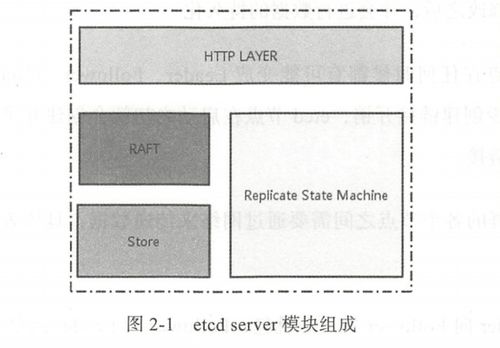

etcd是一个高可用的分布式键值存储系统,由CoreOS团队开发,现已成为Kubernetes等众多云原生系统的核心数据枢纽。它以其强大的一致性保证和可靠性著称,这主要归功于其底层采用的Raft共识算法。etcd高效的数据处理与存储机制,为上层服务提供了坚实的数据基础。本文将深入解析Raft算法如何确保etcd的强一致性,并阐述其数据处理与存储如何支撑服务。

一、核心基石:Raft共识算法与强一致性保证

etcd的核心设计目标是提供强一致性的分布式数据存储。这意味着,在任意时刻,从集群中任何一个健康的节点读取到的数据,都是最新且相同的。Raft算法正是实现这一目标的关键。

1. Raft算法简述

Raft是一种易于理解的共识算法,它将一致性问题分解为几个相对独立的子问题:领导者选举、日志复制和安全性。etcd集群通常由奇数个节点(如3、5、7个)组成,每个节点在Raft中扮演以下三种角色之一:

- 领导者:集群中唯一处理所有客户端写请求的节点,负责将数据变更复制到其他节点。

- 跟随者:被动响应来自领导者的日志复制请求和候选人的选举请求。

- 候选人:在选举超时后,发起新一轮领导者选举的临时状态。

2. 保证强一致性的关键机制

领导者唯一性与日志顺序性:所有写请求都必须通过领导者。领导者将每个写操作(例如 put key value)作为一个日志条目,按顺序追加到自己的日志中,然后并行地复制给所有跟随者。只有当超过半数节点成功持久化该日志条目后,领导者才认为该条目是已提交的,随后将其应用到自己的状态机(即实际的键值存储中)并通知客户端写入成功。这个“大多数节点确认”的机制确保了即使在部分节点故障时,已提交的数据也不会丢失。

日志匹配与安全性约束:Raft通过严格的规则确保所有节点最终拥有一致的日志序列。这包括:选举时,只有拥有最新日志的节点才能成为领导者;领导者会强制覆盖跟随者中与自己冲突的日志部分,确保所有节点日志最终一致。

* 线性化读写:etcd默认提供线性一致性(最强的一致性模型)。对于读请求,etcd也通过领导者处理(或通过一种称为ReadIndex的机制,在不增加日志的情况下由领导者确认自己的领导权),从而确保读取到的永远是最新的、已提交的数据,避免了脏读。

正是通过这些机制,Raft算法在容忍少数节点故障(如一个3节点集群可容忍1个节点故障)的前提下,为etcd提供了强大的强一致性和高可用性保障。

二、数据处理与存储:服务的坚实后盾

在Raft保证了数据的正确性与一致性的基础上,etcd自身高效的数据处理与存储设计,使其能够成为高性能的服务基础设施。

1. 数据模型与接口

键值存储:etcd的数据模型非常简单,是一个分层的键值空间。键是以/分隔的字节数组,类似于文件系统路径,天然支持组织结构和前缀查询。

丰富的操作:除了基本的Put、Get、Delete,etcd支持事务、原子比较并交换、租约(带TTL的键)、监听键前缀变化等。这些特性使得服务可以方便地实现配置管理、服务发现、分布式锁、领导者选举等模式。

2. 存储引擎:MVCC与BoltDB

etcd采用多版本并发控制存储引擎。

- MVCC:每一次对键的修改(

Put)都会生成一个新的修订版本号,旧的数据不会被立即删除。这为系统带来了巨大好处: - 无锁读:读操作可以访问一个历史快照,完全不需要阻塞写操作,极大地提升了并发读性能。

- 历史版本查询与监听:客户端可以查询任意修订版本的数据,或者监听从某个修订版本开始的所有变更。这是Kubernetes实现

list-watch机制、进行状态同步的基础。

- 后端存储:etcd v3版本使用BoltDB(一个单机的嵌入式键值数据库)作为默认后端存储。BoltDB提供稳定的事务支持,且数据以B+树形式组织,对于etcd的键范围查询和前缀扫描非常高效。所有数据(包括键值对、修订版本索引等)都持久化在单个文件中,易于备份和管理。

3. 对上层服务的支持

配置管理:服务可以将动态配置存储在etcd中,并通过监听机制实时获取配置更新,实现配置的集中化管理和动态生效。

服务发现:服务实例启动时,可以在etcd中注册自己的网络地址信息(创建一个带租约的键)。其他服务或负载均衡器通过查询etcd来发现可用的服务实例。当实例故障时,其租约过期,键被自动删除,实现自动下线。

分布式协调:利用etcd的事务、CAS操作和租约,可以轻松构建分布式锁、队列或领导者选举功能,协调多个服务实例的行为,避免冲突。

元数据存储:正如Kubernetes所做的那样,etcd是存储整个系统期望状态和实际状态的事实来源。其强一致性保证了调度器等组件做出决策时基于的是最新的集群状态。

###

etcd的成功在于它将理论(Raft共识算法) 与工程实现(MVCC存储、高效API) 完美结合。Raft算法通过领导者选举、日志复制和安全性规则,在分布式环境中构建了一个强一致性的“虚拟状态机”,这是etcd可靠性的根基。而在此基础上,其简洁的键值模型、MVCC存储引擎以及丰富的原子操作,则为构建高可用的分布式服务提供了强大、灵活且可靠的数据基石。理解etcd的这两个层面,对于设计和运维依赖它的云原生系统至关重要。

如若转载,请注明出处:http://www.bswoniu.com/product/35.html

更新时间:2026-02-24 22:40:31