Hadoop与Spark 大数据时代的处理与存储双引擎

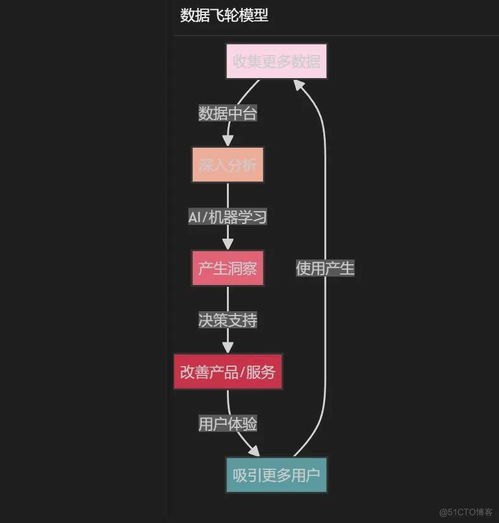

在大数据时代,高效的数据处理与存储技术是企业挖掘数据价值的关键。Hadoop和Spark是这一领域中最为核心和广泛应用的两个开源框架,它们共同构成了现代大数据生态系统的基石,为企业提供了强大的数据处理和存储支持服务。

一、Hadoop:分布式存储与批处理的奠基者

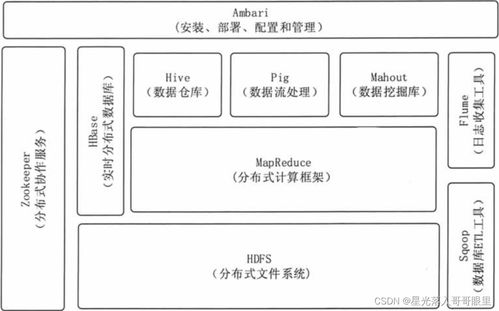

Hadoop是一个由Apache软件基金会开发的分布式系统基础架构,其核心设计目标是能够以可靠、可扩展的方式存储和处理海量数据(从GB到PB级别)。它主要解决了两个根本问题:海量数据的存储和大规模数据的批处理计算。

- 核心组件与存储支持:

- HDFS (Hadoop Distributed File System):这是Hadoop的存储基石。它将大文件分割成多个数据块(默认为128MB或256MB),并分布式地存储在一个由普通商用服务器组成的集群中。HDFS具有高容错性,通过多副本机制(默认3副本)确保数据安全,即使部分节点失效,数据也不会丢失。它提供了高吞吐量的数据访问能力,非常适合一次写入、多次读取的场景,如日志文件、历史数据存档等。

- MapReduce:这是Hadoop最初的计算引擎。它是一种编程模型,用于并行处理大规模数据集。计算任务被分为两个阶段:

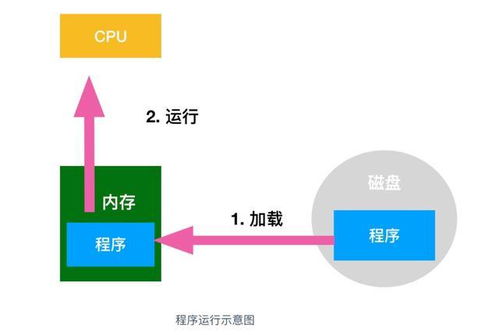

Map(映射)和Reduce(归约)。Map阶段将任务并行化处理,生成中间键值对;Reduce阶段则对中间结果进行汇总。虽然它非常强大且稳定,但其基于磁盘的I/O操作模式在迭代计算(如机器学习)和交互式查询场景下效率较低。

- YARN (Yet Another Resource Negotiator):作为Hadoop 2.0引入的资源管理平台,YARN将资源管理与作业调度/监控功能分离。它负责集群资源(CPU、内存)的统一管理和调度,允许在Hadoop上运行多种计算框架(如MapReduce、Spark、Tez等),使Hadoop从一个单一的计算系统进化成为一个通用的数据操作系统。

Hadoop的服务定位:Hadoop本质上提供了一个低成本、高可靠、可线性扩展的分布式数据湖存储方案(HDFS) 和一个通用资源管理平台(YARN)。其原生的MapReduce引擎是强大的批处理工具,但如今更多作为存储和资源底座,支持上层更高效的计算引擎。

二、Spark:高速内存计算的革新者

Apache Spark是一个专为大规模数据处理而设计的快速、通用、可扩展的计算引擎。它最初是为了弥补MapReduce在迭代和交互式计算上的性能瓶颈而诞生的。Spark的核心优势在于其基于内存的计算。

- 核心特性与处理能力:

- 速度:Spark通过将中间数据缓存到内存中,减少了大量磁盘I/O,使得其在迭代算法(机器学习)和交互式数据查询上的性能比基于磁盘的MapReduce快数十倍甚至上百倍。

- 易用性:Spark提供了丰富的高级API(支持Scala、Java、Python和R),并引入了易于理解的抽象概念,如弹性分布式数据集(RDD) 以及更高级的DataFrame和Dataset,让开发者能够像操作本地集合一样编写分布式程序。

- 通用性:Spark设计了一个统一的引擎,支持多种工作负载。其核心库包括:

- Spark SQL:用于处理结构化数据的模块,支持使用SQL或DataFrame API进行查询。

- Spark Streaming:用于处理实时流数据(微批处理)。

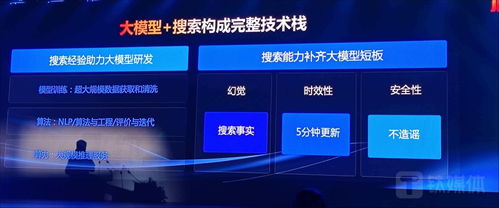

- MLlib:可扩展的机器学习库。

- GraphX:图计算库。

- Structured Streaming:基于Spark SQL引擎构建的、更先进的流处理模型。

Spark的服务定位:Spark本身不提供原生的分布式存储系统。它是一个纯粹的计算引擎,其数据处理能力需要建立在存储系统之上。它最常与HDFS结合使用,从HDFS读取数据,在内存中高速处理,再将结果写回HDFS或其他存储系统(如HBase、S3等)。它可以在YARN上运行,由YARN为其分配和管理资源。

三、协同共生:数据处理与存储的完美搭配

在实践中,Hadoop和Spark并非互斥的替代品,而是互补的伙伴,形成了经典的“Hadoop+Spark”架构。

- Hadoop提供“地基”:HDFS提供海量、廉价、可靠的存储;YARN提供稳定的资源池管理和多租户支持。

- Spark提供“引擎”:作为运行在YARN之上的一个高效计算框架,它从HDFS中读取数据,利用内存进行高速计算,完成复杂的批处理、流处理、机器学习等任务。

类比理解:可以想象一个大型图书馆(Hadoop)。HDFS是图书馆的书架和书库,负责安全地存放所有书籍(数据)。YARN是图书馆的管理员,负责协调谁(哪个计算任务)可以在什么时候使用哪个阅览室(计算资源)。而Spark则是一位极其高效、博学的研究员(计算引擎),他从书库(HDFS)借出大批书籍,在自己的高速思维(内存)中进行分析、关联和,最终产出研究报告(处理结果)。MapReduce则是另一位严谨但速度较慢的研究员,他需要频繁地在书架和书桌间往返(磁盘I/O)。

###

- Hadoop的核心价值在于分布式存储(HDFS) 和资源调度(YARN),其原生计算引擎MapReduce适合超大规模、对延迟不敏感的离线批处理作业。

- Spark的核心价值在于基于内存的高速、通用计算引擎,它极大地提升了数据处理的性能,特别适合迭代计算、交互式查询和实时流处理。

- 两者关系:在现代大数据架构中,Hadoop(尤其是HDFS和YARN)常常作为Spark的存储和资源管理底座。Spark凭借其卓越的性能和易用性,已成为大数据处理领域事实上的标准计算引擎。它们共同为企业提供了从海量数据存储到高效数据分析的全栈式支持服务,驱动着数据驱动型决策和智能应用的发展。

如若转载,请注明出处:http://www.bswoniu.com/product/33.html

更新时间:2026-02-24 17:05:42